hadoop数据恢复(hadoop集群数据恢复)

本篇目录:

1、hadoop的故障检测和自动快速恢复是怎么实现的2、hadoop基于底层大量物理服务器组成的集群对海量数据进行什么处理_百度...3、如何为大数据处理构建高性能Hadoop集群hadoop的故障检测和自动快速恢复是怎么实现的

1、实际上它里面有非常巨大的组成部分,每一个组成部分都很可能出现故障,这就意味着HDFS里的总是有一些部件是失效的,因此,故障的检测和自动快速恢复是HDFS一个很核心的设计目标。

2、支持海量数据的存储:一般来说,HDFS存储的文件可以支持TB和PB级别的数据。检测和快速应对硬件故障:在集群环境中,硬件故障是常见性问题。

3、根据gfs的论文,hadoop应该在数据被再次使用时进行检查,如果发现少了一个备份,会进行数据恢复工作。另一个时间是,机器空闲时会在后台监测数据备份情况。也就是说,数据恢复是自动,这也是hadoop的强大之处嘛。

4、因此错误检测和快速、自动的恢复是HDFS最核心的架构目标。流式数据访问 运行在HDFS上的应用和普通的应用不同,需要流式访问它们的数据集。HDFS的设计中更多的考虑到了数据批处理,而不是用户交互处理。

5、检测和快速应对硬件故障 在集群的环境中,硬件故障是常见的问题。因为有上千台服务器连接在一起,这样会导致高故障率。因此故障检测和自动恢复是hdfs文件系统的一个设计目标。

hadoop基于底层大量物理服务器组成的集群对海量数据进行什么处理_百度...

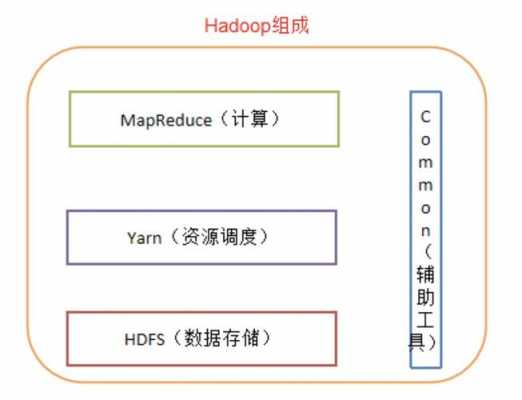

Hadoop是一个开源框架,用于分布式处理海量数据。它通过将数据分散存储在多个节点上,实现了高可用性和高扩展性。Hadoop采用了MapReduce模型,将数据划分为小块,由多个节点并行处理,最终将结果汇总得到最终结果。

mapreduce:是使用较少的代码,完成对海量数据的处理,比如wordCount,统计单词的个数。

Hadoop是一个由Apache基金会所开发的分布式系统基础架构,一个能够对大量数据进行分布式处理的软件框架; Hadoop以一种可靠、高效、可伸缩的方式进行数据处理;用户可以在不了解分布式底层细节的情况下,开发分布式程序。

Hadoop介绍Hadoop是Apache旗下的一个用java语言实现开源软件框架,是一个开发和运行处理大规模数据的软件平台。允许使用简单的编程模型在大量计算机集群上对大型数据集进行分布式处理。

如何为大数据处理构建高性能Hadoop集群

千兆以太网的性能是制约Hadoop系统整体性能的一个主要因素。

操作体系的挑选。操作体系一般使用开源版的RedHat、Centos或许Debian作为底层的构建渠道,要根据大数据渠道所要建立的数据剖析东西能够支撑的体系,正确的挑选操作体系的版本。建立Hadoop集群。

此外,Hadoop/Spark 大数据生态系统中组件众多,每种组件对硬件资源的要求不同,而传统大数据平台建设中,往往很难兼顾资源需求上的差异。

按照大数据处理的流程,分为数据采集、数据存储、数据提取、数据挖掘、数据分析,数据展现和应用。

到此,以上就是小编对于hadoop集群数据恢复的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

-

无相关信息

- 1清新职场环境,招聘优秀保洁服务人员

- 2如何选择适合您的玉泉路搬家公司及联系方式

- 3奉贤商城专业保洁服务标准详解

- 4广西玉林邮政社会招聘面试?

- 5大连搬家服务全解析:选择适合您的搬家公司

- 6丰台区搬家服务推荐及联系方式

- 7快速找到厂洼搬家公司电话,轻松搬家无忧

- 8揭秘万寿路搬家公司电话,快速搬家从此不再烦恼

- 9丰台区搬家攻略:选择最适合你的搬家公司

- 10广州长途搬家服务:如何选择合适的搬家公司及其联系方式

- 11木樨地搬家服务全面指南:如何快速找到合适的搬家公司电话

- 12在宣武门找搬家公司?拨打这些电话轻松搬家!

- 13西二旗搬家服务全攻略:如何找到最靠谱的搬家公司电话

- 14临河搬家公司:专业服务助您轻松搬家

- 15选择异地搬家的物流公司,这几点必须考虑!

- 16可靠的十八里店搬家公司:联系电话与服务指南

- 17创造搬家新体验:大众搬家公司官网全揭秘

- 18武汉优质店铺保洁服务,让您的店面焕然一新

- 19青浦物业小区保洁服务的魅力与选择

- 20如何选择合适的保洁服务?美女保洁员的优势与魅力

- 21提升家政服务水平:普陀家政保洁服务培训解析

- 22提升均安诊所环境的保洁服务方案:健康与舒适双重保障

- 23银行保洁服务方案的标准与最佳实践

- 24提升清洁技能,在西藏寻找最佳保洁服务培训学校

- 25让生活更轻松:大型蓝领公寓保洁服务的优势与选择

- 26义乌商贸区保洁服务:为您的商务环境保驾护航

- 27全面解析绿色保洁服务的多种方法

- 28打造洁净空间:武昌大楼日常保洁服务全解析

- 29无锡到上海搬家公司电话推荐:靠谱服务一键直达

- 30辽宁2023年省考公告时间?